Catatan:Artikel ini awalnya dirancang pada tahun 2015, tetapi diperbarui pada tahun 2019 untuk mencerminkan integrasi baru antara IRI Voracity dan Knime (untuk Konstanz Information Miner), yang sekarang menjadi platform penambangan data sumber terbuka paling kuat yang tersedia.

Penambangan data adalah ilmu untuk memperoleh pengetahuan dari data, biasanya kumpulan data besar tempat informasi, tren, dan wawasan berguna lainnya yang berarti perlu ditemukan. Penambangan data menggunakan pembelajaran mesin dan metode statistik untuk mengekstrak "nugget" informasi yang berguna dari kumpulan data yang seharusnya sangat menakutkan.

Data mining mencakup beberapa disiplin ilmu komputer dan matematika. Ini bukan proses kesatuan karena merupakan istilah umum untuk serangkaian tindakan. Empat tugas umum yang dilakukan saat menambang meliputi: analisis data eksplorasi (EDA), pemodelan deskriptif, pemodelan prediktif, dan penemuan pola.

EDA menggunakan metode visualisasi statistik konvensional atau metode grafis tidak konvensional untuk melihat apakah ada sesuatu yang menarik yang dapat ditemukan dalam data.

Dalam pemodelan deskriptif, data dilewatkan ke rutinitas dan menghasilkan kata kerja (penghasil data) atau kata sifat (deskripsi data) yang berada di belakang pembentukan data. Ini termasuk metode yang mengaitkan data dengan distribusi probabilitas, pengelompokan, dan pemodelan ketergantungan.

Pemodelan prediktif menggunakan metode regresi dan klasifikasi untuk menetapkan standar untuk memprediksi titik data yang tidak diketahui di masa depan. Regresi adalah analisis matematis murni yang menyesuaikan persamaan dengan kumpulan data untuk memprediksi nilai berikutnya. Pemodelan prediktif juga dapat mengandalkan aturan pola dan hubungan (atau bahkan secara khusus mengidentifikasi sebab dan akibat) tren yang ditemukan menggunakan metode Analisis Data Logis (LAD).

Penemuan pola melalui LAD mengklasifikasikan pengamatan baru sesuai dengan klasifikasi pengamatan sebelumnya dan menggunakan fungsi optimasi, kombinatorik, dan Boolean untuk meningkatkan akurasi analisis.

Untuk sebagian besar, metode ini hanya dapat menunjukkan entri data mana yang terkait, tetapi bukan alasan mengapa atau bagaimana mereka terkait. Dimungkinkan untuk menjelaskan apa yang menjadi ciri satu kelas/cluster dari yang lain dengan menemukan aturan atau pola ini, dan topiknya dicantumkan dalam berbagai cara tergantung pada data itu sendiri.

Aplikasi untuk penambangan data dapat berkisar dari pemasaran bisnis hingga obat-obatan, dari deteksi penipuan di perbankan dan asuransi hingga astronomi, dari manajemen sumber daya manusia hingga industri pemasaran katalog, dan sebagainya. Profesi medis merasa berguna untuk membedakan antara atribut orang dengan tingkat perkembangan penyakit yang berbeda. Toko ritel sekarang menggunakan penambangan data untuk lebih memahami kebiasaan belanja konsumen, mencatat item mana yang dibeli bersama dan hubungannya, serta cara terbaik untuk beriklan kepada pelanggan mereka. Dan sebagian besar dunia korporat sekarang bergantung pada penambangan data untuk menghitung, mengeksekusi, dan membenarkan keputusan bisnis utama.

Namun, seperti yang sekarang diketahui semua orang dari liputan media yang intens baru-baru ini tentang skandal catatan telepon NSA-Verizon, penambangan data juga bisa sangat kontroversial. Untuk berjaga-jaga jika Anda hidup di bawah batu, berikut sinopsis singkatnya:

Pada tanggal 5 Juni 2013, surat kabar harian Inggris bernama The Guardian menerbitkan laporan eksklusif bahwa jutaan catatan pelanggan dari Verizon, salah satu penyedia telekomunikasi terbesar di AS, dikumpulkan oleh Badan Keamanan Nasional AS, sebagai tanggapan atas perintah rahasia dari Pengadilan Pengawasan Intelijen Asing AS. Layanan Jaringan Bisnis Verizon terpaksa menyerahkan semua metadata telepon yang dibuat oleh penyedia layanan seluler di AS dan di luar negeri. Akibatnya, kritik bi-partisan dan universal terhadap pemerintahan Obama kemudian meletus dari kelompok advokasi hak-hak sipil dan outlet media berita, mengklaim penyalahgunaan kekuasaan eksekutif oleh presiden. Tidak ada resolusi dari insiden ini yang terlihat pada penulisan artikel ini. Namun, tidak diragukan lagi, ini akan tetap menjadi contoh utama tentang bagaimana penambangan data terkadang dapat dilihat secara negatif, terutama yang berkaitan dengan masalah privasi dan masyarakat umum.

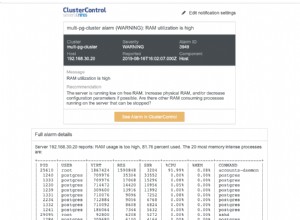

Ketika berhadapan dengan volume besar data statis atau dinamis, pasti akan ada masalah kinerja komputasi dan I/O yang terkait. Dengan database yang berisi terabyte dan exabytes data, menyisir data dapat memakan banyak waktu, dan algoritme penambangan harus berjalan dengan sangat efisien. Beberapa kesulitan lain termasuk overfitting dan data yang berisik.

Overfitting biasanya berarti tidak ada cukup data yang tersedia. Model data (dalam hal ini, deskripsi global data) menjadi terlalu kompleks karena memiliki terlalu banyak parameter relatif terhadap jumlah pengamatan. Ini melebih-lebihkan fluktuasi kecil pada data, sehingga mengurangi keandalan model sebagai dasar untuk membuat prediksi.

Data berisik, di sisi lain, mengacu pada terlalu banyak jenis data yang salah. Data yang tidak berarti, salah, tidak terstruktur (tidak dapat dibaca) atau rusak meningkatkan persyaratan penyimpanan dan/atau memerlukan analisis statistik untuk disingkirkan sebelum dapat menghambat akurasi penambangan data. Algoritme penambangan data yang baik memperhitungkan data yang bising.

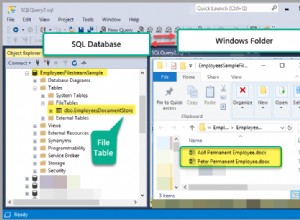

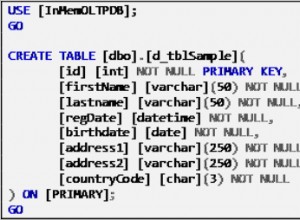

Data mining adalah satu langkah dalam proses yang lebih besar yang dikenal sebagai penemuan pengetahuan dalam database (KDD). KDD pertama-tama dimulai dengan persiapan data: pemilihan, pra-pemrosesan, dan transformasi data, di mana Anda menentukan apa yang ingin Anda pelajari dan menyiapkannya dengan cara yang dapat digali. Itu mewakili data sebagai matriks m-n dan dengan representasi numerik dari elemen setiap vektor data. Selanjutnya, kamu milikku. Dan akhirnya, Anda bisa menggunakan cara lama untuk menafsirkan dan menganalisis informasi itu. Kemudian, jika pola dan tren yang tersembunyi masih belum cukup jelas, Anda harus menggali lebih dalam.

Peran IRI dalam penambangan data dan proses KDD adalah menyiapkan dan menyusun ulang data besar untuk dianalisis melalui berbagai fungsi transformasi data berkinerja tinggi. Secara khusus, paket manipulasi data CoSort IRI dapat dengan cepat memfilter, memanipulasi, dan memformat ulang data sehingga dapat diproses oleh algoritme penambangan data seperti rangkaian perangkat lunak penambangan data ini. CoSort juga merupakan mesin pemrosesan data default di platform manajemen data IRI Voracity, yang dirancang untuk berbagai pekerjaan pembuatan profil, persiapan, dan perselisihan data.

Bagi mereka yang bekerja dengan CoSort di IRI Workbench GUI, BIRT adalah plug-in Eclipse gratis dengan pelaporan grafis dan kemampuan intelijen bisnis yang mencakup beberapa fitur analitik dan penambangan. Baik CoSort dan BIRT Analytics menggunakan Eclipse IDE. Dengan dukungan driver data Open Data Access (ODA) yang masuk ke CoSort, integrasi aliran data antara kedua plug-in juga mulus dan memungkinkan analisis what-if yang lebih cepat.

Bagi mereka yang bekerja dengan Voracity pada tahun 2019 dan seterusnya, kami menyarankan untuk menginstal penyedia inti untuk Platform Knime Analytics gratis ke IRI Workbench. Dalam panel kaca Eclipse yang sama, node sumber (penyedia) Voracity untuk Knime dapat menyerahkan data mentah yang disiapkan Voracity dalam memori ke node Knime untuk aplikasi yang memerlukan analisis statistik dan prediktif, penambangan data dan pembelajaran mesin/dalam, jaringan saraf dan kecerdasan buatan.

Kontributor artikel ini termasuk Roby Poteau dan David Friedland