Navistar adalah produsen truk komersial global terkemuka. Dengan armada 350.000 kendaraan, perawatan tak terjadwal dan kerusakan kendaraan menciptakan gangguan berkelanjutan pada bisnis mereka. Navistar membutuhkan platform diagnostik yang akan membantu mereka memprediksi kapan kendaraan membutuhkan perawatan untuk meminimalkan waktu henti. Platform ini harus dapat mengumpulkan, menganalisis, dan menyajikan data dari lebih dari 70 data telematika dan sensor dari setiap kendaraan di armada mereka, termasuk data yang mengukur kinerja engine, suhu cairan pendingin, kecepatan truk, dan keausan rem. Navistar beralih ke Cloudera untuk membantu membangun platform diagnostik jarak jauh berkemampuan IoT, yang disebut OnCommand® Connection, untuk memantau kesehatan kendaraan mereka dan meningkatkan waktu operasional kendaraan.

Blog ini mendemonstrasikan penggunaan teknologi serupa untuk mengatasi masalah yang lingkupnya jauh lebih kecil tetapi dengan paralel dengan yang dihadapi Navistar. Data diambil dari Corvette yang sangat dimodifikasi dan berkinerja tinggi (lihat Gambar 1) untuk menunjukkan langkah-langkah memuat data dari sumber eksternal, memformatnya menggunakan Apache NiFi, mendorongnya ke sumber aliran melalui Apache Kafka, dan menyimpannya menggunakan Apache HBase untuk analisis tambahan.

Gambar 1. Corvette 2008 dengan Modifikasi Mesin 6.8L

Untuk contoh khusus ini, Corvette yang bersangkutan telah mengganti semua komponen mesin pabrik asli demi suku cadang berperforma lebih tinggi. Mesin dirobek sampai ke cangkangnya, silinder dibocorkan, poros engkol dan poros bubungan diganti, dan piston dan batang penghubung baru dipasang, mengejar target ~600 tenaga kuda (lihat Gambar 2). Agar konfigurasi mesin baru ini berfungsi dengan baik, perangkat lunak mesin mengalami perombakan total. Sementara menekan throttle menjadi lebih dramatis secara signifikan, konsekuensi yang tidak diinginkan adalah diagnostik asli dan sistem kesalahan mobil tidak lagi akurat dan oleh karena itu harus dinonaktifkan.

Gambar 2. Mesin tengah dibangun kembali dengan semua internal baru yang mengkilap

Untuk menangkap dan menganalisis data sensor Corvette, diperlukan jalur agar data mengalir dari mobil ke platform analitik dan diagnostik alternatif. Langkah pertama adalah menghubungkan laptop ke port diagnostik Corvette (lihat Gambar 3) untuk mengimpor data sensor ke lokasi penyimpanan berbasis cloud. S3 digunakan untuk proyek ini.

Gambar 3. Laptop terhubung ke port diagnostik melalui USB

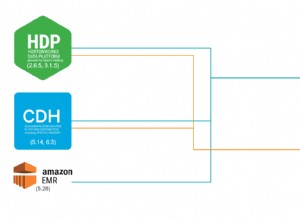

Langkah selanjutnya adalah menggunakan Cloudera Data Platform (CDP), platform multi-fungsi dan multi-analisis Cloudera, untuk mengakses layanan yang diperlukan untuk memindahkan data ke tujuan penyimpanan akhir untuk analisis tambahan. Menggunakan CDP Public Cloud, 3 hub data disiapkan, masing-masing menghosting satu set layanan sumber terbuka yang sudah dikemas sebelumnya (lihat Gambar 4):

- Penyiapan pertama adalah NiFi, layanan yang dibuat untuk mengotomatisasi dan mengelola aliran data. NiFi digunakan untuk mengimpor, memformat, dan memindahkan data Corvette dari sumber ke titik penyimpanan terakhirnya.

- Selanjutnya adalah menyiapkan Kafka, layanan streaming waktu nyata yang memungkinkan data dalam jumlah besar tersedia sebagai streaming. Kafka memberikan kemampuan untuk pemrosesan aliran data, sementara juga memungkinkan pengguna lain opsi untuk berlangganan aliran data. Dalam contoh ini tidak ada pelanggan; namun, ini adalah konsep penting yang layak untuk didemonstrasikan tentang cara menyiapkannya.

- Pengaturan terakhir adalah HBase, database operasional berorientasi kolom yang sangat skalabel yang menyediakan akses baca/tulis waktu nyata. Setelah data diimpor ke HBase, Phoenix akan digunakan untuk melakukan kueri dan mengambil data.

Gambar 4. Diagram aliran data korvet dari sumber ke kueri.

Membangun platform diagnostik menggunakan CDP untuk memantau kesehatan dan kinerja Corvette adalah latihan yang berhasil. Menggunakan NiFi dan Kafka untuk memformat dan mengalirkan data sensor ke HBase kini memungkinkan rekayasa dan pemrosesan data tingkat lanjut dilakukan terlepas dari seberapa besar kumpulan data tumbuh.

Langkah Selanjutnya

Untuk melihat semua ini dalam tindakan, silakan lihat tautan di bawah ke beberapa sumber berbeda yang menunjukkan proses yang telah dibuat.

- Video – Jika Anda ingin melihat dan mendengar bagaimana ini dibuat, lihat video singkat 5 menit yang menampilkan navigasi waktu nyata dari CDP yang menjalankan NiFi, Kafka dan HBase.

- Tutorial – Jika Anda ingin melakukannya dengan kecepatan Anda sendiri, lihat panduan mendetail dengan tangkapan layar dan petunjuk baris demi baris tentang cara menyiapkannya.

- MeetUps – Jika Anda ingin berbicara langsung dengan para ahli dari Cloudera dan bahkan pemilik Corvette ini, silakan bergabung dalam pertemuan virtual untuk melihat presentasi langsungnya. Akan ada waktu untuk tanya jawab langsung di akhir.

- Halaman Pengguna CDP – Untuk mempelajari tentang sumber daya CDP lain yang dibuat untuk pengguna, termasuk video tambahan, tutorial, blog, dan acara, klik tautannya.