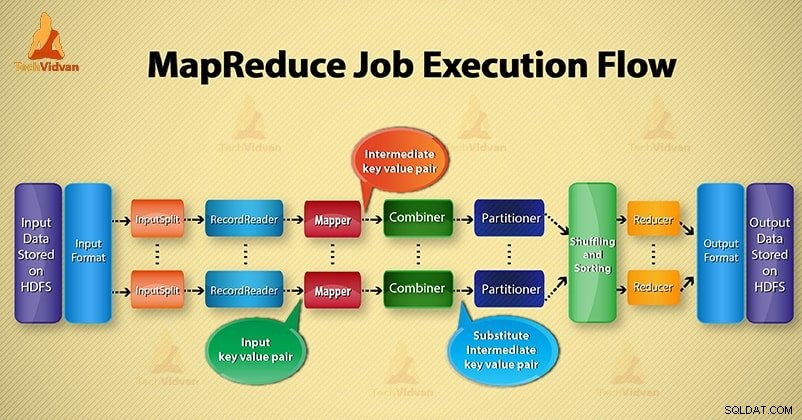

Dalam Hadoop . ini blog, kami akan memberikan Anda aliran eksekusi pekerjaan MapReduce ujung ke ujung. Disini kami akan menjelaskan setiap komponen yang merupakan bagian dari MapReduce yang bekerja secara detail.

Blog ini akan membantu Anda untuk menjawab bagaimana Hadoop MapReduce bekerja, bagaimana data mengalir di MapReduce, bagaimana pekerjaan Mapreduce dijalankan di Hadoop?

Apa itu MapReduce?

Hadoop MapReduce adalah lapisan pemrosesan data. Ini memproses sejumlah besar data terstruktur dan tidak terstruktur yang disimpan dalam HDFS. MapReduce memproses data secara paralel dengan membagi pekerjaan ke dalam kumpulan tugas independen. Jadi, pemrosesan paralel meningkatkan kecepatan dan keandalan.

Pemrosesan data Hadoop MapReduce berlangsung dalam 2 fase - Fase Pemetaan dan Pengurangan.

- Fase peta- Ini adalah tahap pertama dari pengolahan data. Pada fase ini, kami menentukan semua logika kompleks/aturan bisnis/kode mahal.

- Mengurangi fase- Ini adalah pemrosesan tahap kedua. Dalam fase ini, kami menentukan pemrosesan ringan seperti agregasi/penjumlahan.

Langkah-langkah alur Eksekusi Pekerjaan MapReduce

MapReduce memproses data dalam berbagai fase dengan bantuan komponen yang berbeda. Mari kita bahas langkah-langkah pelaksanaan pekerjaan di Hadoop.

1. File Masukan

Dalam file input, data untuk pekerjaan MapReduce disimpan. Dalam HDFS , file input berada. Format file input adalah arbitrer. File log berbasis baris dan format biner juga dapat digunakan.

2. Format Masukan

Setelah itu InputFormat mendefinisikan cara membagi dan membaca file input ini. Ini memilih file atau objek lain untuk input. InputFormat membuat InputSplit.

3. Pemisahan Input

Ini mewakili data yang akan diproses oleh individu Mapper . Untuk setiap pemisahan, satu tugas peta dibuat. Jadi jumlah tugas peta sama dengan jumlah InputSplits. Kerangka membagi dibagi menjadi catatan, yang proses mapper.

4. Pembaca Rekam

Ini berkomunikasi dengan inputSplit. Dan kemudian mengonversi data menjadi pasangan nilai kunci cocok untuk dibaca oleh Mapper. RecordReader secara default menggunakan TextInputFormat untuk mengonversi data menjadi pasangan nilai kunci.

Ini berkomunikasi dengan InputSplit sampai selesainya pembacaan file. Ini memberikan byte offset untuk setiap baris yang ada dalam file. Kemudian, pasangan nilai kunci ini selanjutnya dikirim ke mapper untuk diproses lebih lanjut.

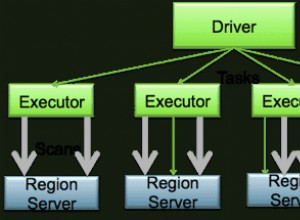

5. Pemeta

Ini memproses catatan input yang dihasilkan oleh RecordReader dan menghasilkan pasangan nilai kunci perantara. Output antara benar-benar berbeda dari pasangan input. Keluaran dari mapper adalah kumpulan lengkap dari pasangan nilai kunci.

Kerangka kerja Hadoop tidak menyimpan output mapper di HDFS. Itu tidak menyimpan, karena data bersifat sementara dan menulis di HDFS akan membuat banyak salinan yang tidak perlu. Kemudian Mapper meneruskan output ke penggabung untuk diproses lebih lanjut.

4. Penggabung

Combiner adalah Mini-reducer yang melakukan agregasi lokal pada output mapper. Ini meminimalkan transfer data antara mapper dan peredam. Jadi, ketika fungsionalitas penggabung selesai, kerangka kerja meneruskan output ke pembuat partisi untuk diproses lebih lanjut.

5. Pemisah

Partisi muncul jika kita bekerja dengan lebih dari satu peredam. Dibutuhkan output dari combiner dan melakukan partisi.

Partisi output terjadi berdasarkan kunci di MapReduce. Dengan fungsi hash, kunci (atau subset dari kunci) menurunkan partisi.

Berdasarkan nilai kunci di MapReduce, partisi dari setiap keluaran penggabung dilakukan. Dan kemudian catatan yang memiliki nilai kunci yang sama masuk ke partisi yang sama. Setelah itu, setiap partisi dikirim ke peredam.

Mempartisi dalam eksekusi MapReduce memungkinkan pemerataan output peta melalui peredam.

6. Mengacak dan Mengurutkan

Setelah dipartisi, output dikocok ke node reduksi. Pengacakan adalah pergerakan fisik data yang dilakukan melalui jaringan. Saat semua pembuat peta selesai dan mengacak output pada node peredam.

Kemudian framework menggabungkan output dan sortir perantara ini. Ini kemudian diberikan sebagai masukan untuk mengurangi fase.

7. Peredam

Reducer kemudian mengambil set pasangan kunci-nilai menengah yang dihasilkan oleh pembuat peta sebagai input. Setelah itu jalankan fungsi peredam pada masing-masing untuk menghasilkan output.

Output dari peredam adalah output akhir. Kemudian framework menyimpan output pada HDFS.

8. RecordWriter

Ia menulis pasangan nilai kunci keluaran ini dari fase Peredam ke file keluaran.

9. OutputFormat

OutputFormat mendefinisikan cara RecordReader menulis pasangan nilai kunci output ini dalam file output. Jadi, contoh yang disediakan oleh Hadoop menulis file dalam HDFS. Jadi instance OutputFormat menulis output akhir dari peredam pada HDFS.

Kesimpulan

Kami telah mempelajari langkah demi langkah alur eksekusi pekerjaan MapReduce. Saya harap blog ini banyak membantu Anda untuk memahami cara kerja MapReduce.

Jika masih, Anda memiliki pertanyaan terkait dengan alur eksekusi pekerjaan MapReduce, sehingga Anda dapat berbagi dengan kami di bagian komentar yang diberikan di bawah ini. Kami akan mencoba yang terbaik untuk menyelesaikannya.