Data adalah kekuatan dan dengan kekuatan itu muncul tanggung jawab besar. Salah satu kendala terbesar dalam data adalah mengidentifikasi duplikat dan menghilangkan duplikasi.

Tujuan dari deduplikasi data adalah untuk menghilangkan data yang berlebihan dalam bisnis Anda. Duplikat dibuat di semua area bisnis Anda seperti perwakilan penjualan memasukkan catatan baru tanpa memeriksa database terlebih dahulu, pemasar mengunggah daftar pembeli potensial tanpa memeriksa apakah catatan itu ada dan pelanggan yang memasukkan informasi mereka lagi karena mereka lupa. sudah memiliki akun dengan Anda.

Deduplikasi data memastikan manajemen data yang tepat dari catatan tersebut, mengurangi penyimpanan data, komunikasi pemasaran yang lebih efektif, dan analisis prediktif yang lebih baik. Catatan duplikat sebenarnya dapat memberikan dampak besar pada pembelajaran mesin dan catatan ilmu data dengan secara teoritis memberi pelanggan kekuatan prediksi dua kali lipat dan oleh karena itu menciptakan bias dalam output.

Namun, dengan setiap ide bagus ada risiko dan dalam strategi de-duplikasi di mana data dihapus sebagian besar waktu, mungkin ada kesalahan yang melekat.

Pemrosesan Sebaris atau Pasca

Proses deduplikasi sebaris de-dupe data saat diproses. Ini berarti mengurangi jumlah data segera yang besar tetapi sering memiliki masalah kinerja dengan jumlah sumber daya yang dibutuhkan untuk menjalankan seperti strategi. Namun, itu berarti Anda membutuhkan ruang disk mentah yang jauh lebih sedikit karena data tidak pernah benar-benar dikirim sejak awal karena deduplikasi dilakukan di bagian depan.

Penting bagi Anda untuk memastikan bahwa Anda memiliki kekuatan pemrosesan untuk deduplikasi sebaris dan itu tidak memengaruhi kinerja. Kesalahan lainnya adalah mengasumsikan bahwa tidak ada kasus untuk memiliki duplikat. Ada kebutuhan yang sah untuk memiliki duplikat di sistem Anda. Alasannya bisa karena alasan penagihan, layanan pelanggan, penjualan, dan pemasaran, oleh karena itu, sebaiknya konsultasikan dengan semua departemen yang menyentuh data sebelum menerapkan pemrosesan in-line.

Algoritma

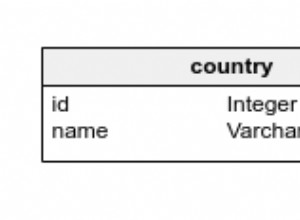

Deduplikasi hanya sebagus algoritme yang diberikannya yaitu bagaimana catatan duplikat ditemukan di tempat pertama? Mari kita asumsikan kita memiliki 100 salinan file di sistem kita karena setiap karyawan memiliki versi mereka sendiri. Alih-alih menyimpan banyak salinan, praktik yang baik memberi tahu Anda untuk hanya menyimpan satu dan meminta semua karyawan menunjuk ke sana. Bagaimana jika salah satu karyawan membuat perubahan pada file mereka sendiri yang berarti sedikit berbeda dari yang lain? Anda berisiko kehilangan data. Penting untuk memastikan bahwa aturan apa pun yang Anda tetapkan masuk akal dan tidak mulai menghapus kumpulan data unik secara tidak sengaja.

Ada beberapa algoritme umum yang digunakan untuk deduplikasi data seperti SHA-1 atau MD5 dan Struktur Pohon Pencarian Biner yang perlu ditinjau untuk menemukan apa yang paling sesuai untuk Anda.

Sementara de-duping set data dalam contoh di atas dapat dengan mudah ditangani oleh ilmuwan data. Untuk catatan penjualan dan pemasaran, ini sedikit lebih sulit. Pertimbangkan, bahwa bisnis yang berbeda mendefinisikan duplikat secara berbeda, itu bukan lagi tugas ilmuwan data melainkan untuk kepala departemen yang berbeda. Oleh karena itu, langkah pertama adalah mengidentifikasi apa yang membuat duplikat. Misalnya, ambil raksasa ritel seperti Walmart. Untuk perusahaan distribusi, setiap lokasi Walmart akan dianggap sebagai catatan unik, namun, untuk perusahaan perangkat lunak yang menjual ke Walmart, mereka akan menganggap semua lokasi sebagai duplikat karena mereka hanya ingin menjual ke kantor pusat. Hal yang sama dapat dikatakan untuk menjual ke P&G di mana beberapa bisnis menjual secara individual ke setiap merek. Oleh karena itu, mereka ingin memisahkan semuanya dan menerapkan tautan induk/anak alih-alih menghilangkan penipuan untuk mengidentifikasi merek yang berbeda. Oleh karena itu, sebelum menghapus duplikat, pastikan Anda memiliki semua aturan yang ditentukan sebelum mencari tahu algoritme yang akan digunakan untuk menghapus data palsu.

Enkripsi

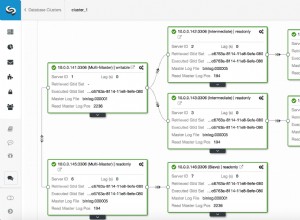

Dengan perlindungan data, sering terjadi bahwa tim keamanan akan memiliki data yang dienkripsi saat masuk ke bisnis yang berarti tidak mungkin untuk menipu karena semuanya unik dalam konteks ini. Jika Anda menggunakan produk replikasi dan enkripsi yang sejalan dengan perangkat lunak deduplikasi, kemungkinan besar file akan direplikasi karena tidak dapat memilihnya sebagai blok penyimpanan unik.

Produk perlindungan data terkadang sadar akan deduplikasi, tetapi penting bagi Anda untuk mempertimbangkan bagaimana semuanya terintegrasi bersama.

Deduplikasi manual

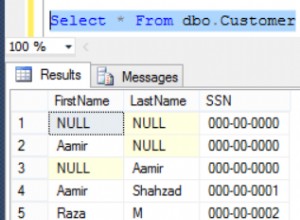

Sebagian besar bisnis akan mencoba membocorkan database mereka secara manual dengan menghabiskan banyak sumber daya dan waktu dengan risiko kesalahan manusia yang besar. Selain itu, dengan kumpulan data yang sangat besar, hampir tidak mungkin bagi proses manual untuk memahami semuanya.

Misalnya, bagaimana jika John Smith membeli sepasang sepatu di situs web Anda hari ini. Dia kembali besok tetapi mendaftar sebagai J Smith karena dia lupa detail loginnya. Minggu depan, dia mendaftar lagi tetapi dengan alamat email yang berbeda. Saya hanya menyebutkan tiga bidang data di sini, tetapi sudah mulai rumit, jadi bayangkan jika Anda memiliki 200 bidang data pelanggan, bagaimana Anda memastikan itu tetap unik?

Penting untuk membuat algoritme lengkap sendiri jika melakukan proses manual atau memperoleh alat pembersihan data untuk melakukannya untuk Anda, menghemat semua waktu dan tenaga.

Cadangan

Deduplikasi bisa salah! Sebelum menghapus duplikat, penting agar semuanya dicadangkan dan Anda dapat menyelesaikan masalah apa pun dengan cepat. Kembali ke contoh sebelumnya, bagaimana jika kita menemukan bahwa John Smith dan J Smith sebenarnya adalah orang yang berbeda dan perlu mendapatkan akunnya kembali? Anda memerlukan proses yang dapat melakukan hal itu, yang merupakan persyaratan hukum sekarang di UE (GDPR).

Strategi deduplikasi data penting karena bisnis menumbuhkan jejak digital mereka. Dengan begitu banyak saluran komunikasi, hanya satu rekaman duplikat yang memiliki kapasitas untuk menciptakan bias dan berpotensi mengarah pada keputusan yang salah. Meskipun demikian, hal itu harus dilakukan dengan benar untuk menghindari konsekuensi dari penghapusan catatan yang salah atau pemberian algoritma yang salah dan mengurangi kecepatan bisnis. Pastikan bahwa deduplikasi data sepenuhnya terbentuk dalam strategi tata kelola data Anda.