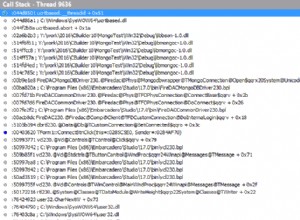

Cara efisien untuk menulis ke mongodb dari pyspark adalah dengan menggunakan MongoDB Konektor Percikan . Konektor akan mengubah data menjadi format BSON dan menyimpannya ke mongodb. Katakanlah Anda memiliki spark dataframe bernama df yang ingin Anda simpan di mongodb. Anda dapat mencoba:

from pyspark.sql import SparkSession, SQLContext

from pyspark import SparkConf, SparkContext

sc = SparkContext()

spark = SparkSession(sc)

df.write.format("com.mongodb.spark.sql.DefaultSource").mode("append").option("spark.mongodb.output.uri","mongodb://username:example@sqldat.com_details:27017/db_name.collection_name?authSource=admin").save()

Jika Anda menggunakan buku catatan, tulis ini di atas-

%%configure

{"conf": {"spark.jars.packages": "org.mongodb.spark:mongo-spark-connector_2.11:2.3.2"}}

Jika Anda menggunakan perintah spark-submit:

spark-submit --conf spark.pyspark.python=/usr/bin/anaconda/envs/py35/bin/python3.5 --packages org.mongodb.spark:mongo-spark-connector_2.11:2.3.1 file_name.py