Anda perlu memanfaatkan perpustakaan ini:https://github.com/RedisLabs/spark-redisabersama dengan toples terkait yang diperlukan (bergantung pada versi spark+scala yang Anda gunakan).

Dalam kasus saya, saya telah menginstal 3 toples di spark cluster(Scala=2.12) spark terbaru:

- spark_redis_2_12_2_6_0.jar

- commons_pool2_2_10_0.jar

- jedis_3_6_0.jar

Sepanjang konfigurasi untuk menghubungkan ke redis:

Pengaturan konfigurasi cluster

spark.redis.auth PASSWORD

spark.redis.port 6379

spark.redis.host xxxx.xxx.cache.windows.net

Pastikan Anda memiliki Azure redis 4.0, perpustakaan mungkin memiliki masalah dengan 6.0. Contoh kode untuk mendorong:

from pyspark.sql.types import StructType, StructField, StringType

schema = StructType([

StructField("id", StringType(), True),

StructField("colA", StringType(), True),

StructField("colB", StringType(), True)

])

data = [

['1', '8', '2'],

['2', '5', '3'],

['3', '3', '1'],

['4', '7', '2']

]

df = spark.createDataFrame(data, schema=schema)

df.show()

--------------

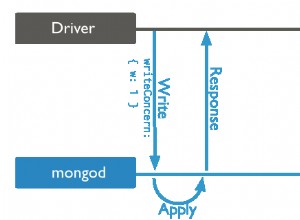

(

df.

write.

format("org.apache.spark.sql.redis").

option("table", "mytable").

option("key.column", "id").

save()

)