Pos blog ini dipublikasikan di Hortonworks.com sebelum merger dengan Cloudera. Beberapa tautan, sumber daya, atau referensi mungkin tidak lagi akurat.

Komputer semakin pintar dan kita tidak.

–Tim Berners Lee, Pengembang Web

Google, Amazon, dan Netflix telah mengkondisikan kami. Sebagai konsumen, kami mengharapkan aplikasi cerdas yang memprediksi, menyarankan, dan mengantisipasi setiap langkah kami. Kami ingin mereka menyaring jutaan kemungkinan dan menyarankan beberapa yang sesuai dengan kebutuhan kami. Kami menginginkan aplikasi yang membawa kami dalam perjalanan yang dipersonalisasi melalui dunia dengan kemungkinan tak terbatas.

Perjalanan yang dipersonalisasi ini memerlukan sistem untuk menyimpan dan memahami volume data yang besar dalam jumlah waktu yang dapat diterima. Ini adalah setelan kuat Hadoop sejak hari pertama.

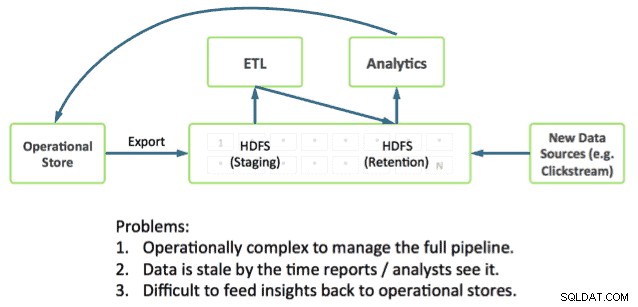

Menyampaikan perjalanan juga membutuhkan aplikasi untuk langsung terintegrasi dengan analisis mendalam. Ini tetap menjadi tantangan karena sebagian besar sistem operasional berjalan di luar Hadoop, menempatkan data operasional dan analitik di tempat terpisah.

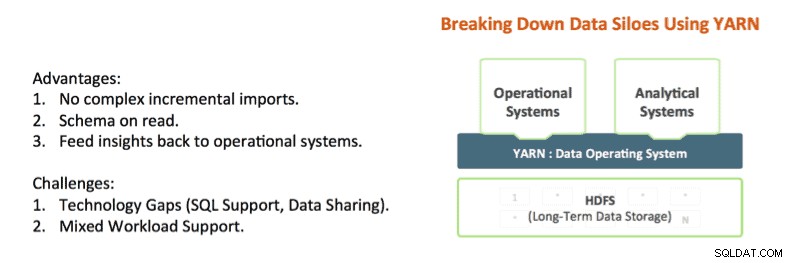

Teknologi seperti Apache Hadoop YARN dan Apache Slider mulai memecah silo ini. YARN memberikan kontrol isolasi sumber daya Hadoop yang memungkinkan untuk menganalisis data aplikasi secara mendalam di tempat sambil memberikan jawaban dalam kerangka waktu yang dapat diterima. Dan Apache Slider memudahkan penerapan sistem operasional yang sudah berjalan lama ke Hadoop.

YARN adalah pusat arsitektur Hadoop yang memungkinkan beberapa mesin pemrosesan data seperti SQL interaktif, streaming real-time, ilmu data, dan pemrosesan batch untuk menangani data yang disimpan dalam satu platform, membuka pendekatan analitik yang sama sekali baru. Hal ini memberikan integrasi sistem operasional dan analitik yang mulus dan landasan di mana perusahaan dapat membangun Arsitektur Data Modern (MDA).

Kecanggihan Hadoop

Hal ini dimungkinkan untuk memadukan operasional dan analitik bersama di Hadoop hari ini, dan faktanya kami melihat banyak pelanggan kami melakukannya.

Potongan yang Anda butuhkan sudah ada di Hadoop:

- Apache HBase adalah database NoSQL untuk Hadoop dan hebat dalam pembaruan cepat dan akses data latensi rendah.

- Apache Phoenix (dipelopori oleh Salesforce) adalah kulit SQL untuk data di HBase. Phoenix sedang menyelidiki integrasi dengan manajer transaksi seperti Tephra (dari Cask).

- Apache Hive adalah mesin SQL de-facto untuk Hadoop yang menyediakan analitik SQL terdalam dan mendukung pola kueri batch dan interaktif. Lihat Stinger. Postingan berikutnya kami untuk kemajuan seperti Hive LLAP.

Kami melihat pelanggan kami menggunakan bagian ini hari ini untuk membangun aplikasi dengan analisis mendalam, misalnya pola yang sangat umum kami lihat meliputi:

- Menggunakan HBase sebagai penyimpanan data operasional online untuk pembaruan cepat pada data panas seperti partisi saat ini untuk jam, hari, dll.

- Melaksanakan kueri operasional secara langsung terhadap HBase menggunakan Apache Phoenix.

- Penuaan data dalam tabel HBase ke Hive menggunakan pola ETL standar.

- Melakukan analisis SQL mendalam menggunakan Hive

Ini berhasil tetapi menciptakan sejumlah kerumitan bagi pengembang. Misalnya:

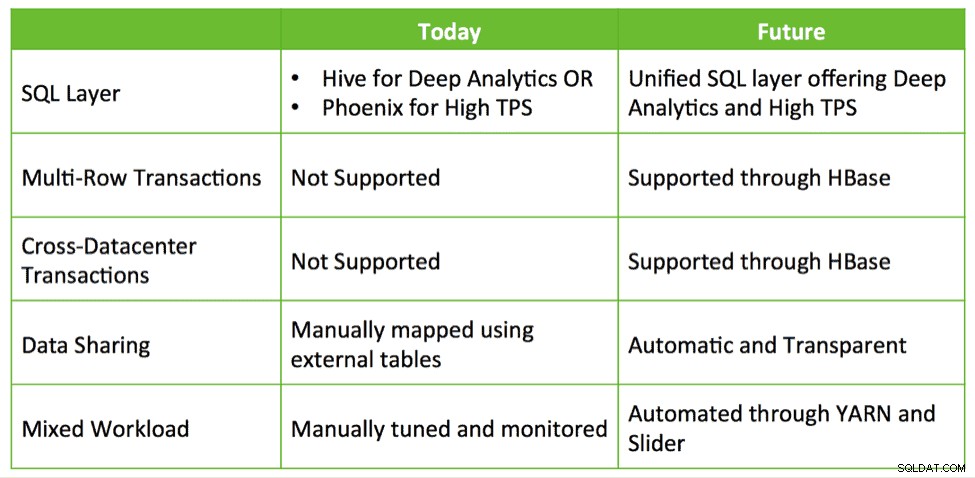

- Antarmuka SQL mana yang saya gunakan dan kapan? Apakah saya menggunakan Hive yang menawarkan SQL dalam tetapi TPS rendah? Atau apakah saya menggunakan Phoenix dengan TPS tinggi dan SQL dasar? Atau apakah saya menggunakan keduanya?

- Jika saya menggunakan keduanya, bagaimana cara berbagi data antara Hive dan HBase?

- Bagaimana cara menyetel klaster saya sehingga saya dapat berhasil menemukan HBase dan Hive saat memenuhi SLA saya?

Pertanyaan-pertanyaan ini menunjukkan bahwa integrasi yang lebih dalam diperlukan untuk menyederhanakan pembuatan aplikasi dengan analisis mendalam di Hadoop.

HBase dan Hive:Lebih Baik Bersama

Peluang apa yang ada untuk integrasi yang lebih dalam? Saat ini, pelanggan sedang menyusun solusi yang memanfaatkan HBase, Phoenix, Hive, dll. untuk membangun sistem loop tertutup yang dipesan lebih dahulu untuk data operasional dan analitik SQL. Kami merasa ada peluang untuk menyediakan integrasi out-of-the-box dengan kemudahan penggunaan dan kemampuan tambahan seperti transaksi, failover pusat data lintas, dll.

Hive, HBase, dan Phoenix semuanya memiliki komunitas pengembang yang sangat aktif dan digunakan dalam produksi di banyak organisasi. Ini adalah kemampuan operasional yang solid dan terbukti yang dapat menjadi dasar dan masa depan pemrosesan transaksi di Hadoop.

Jadi, dengan menggunakan pendekatan yang sama dengan Stinger Initiative yang sukses, Hortonworks berupaya berinvestasi lebih jauh dalam proyek-proyek inti ini dan membangun momentum daripada mengabaikannya dan memulai dari awal. Kami berencana untuk berinvestasi dalam peningkatan yang memajukan pengalaman operasional dan analitis terintegrasi melalui Hive dan HBase yang terintegrasi erat. Ini membahas kasus penggunaan yang nyata dan menarik dengan cara yang mempertahankan investasi dan mendorong nilai nyata bagi pelanggan.

Kami melihat empat area pengembangan utama untuk membantu mewujudkan visi aplikasi cerdas:

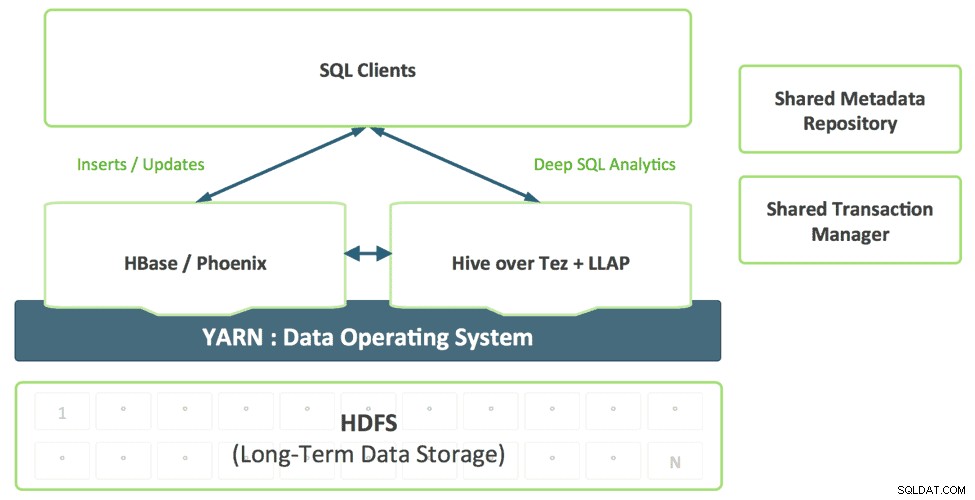

1. Lapisan SQL Terpadu dengan Hive

Pengembang yang membangun aplikasi SQL tidak harus memilih antara solusi SQL yang berbeda, masing-masing dengan kekuatan dan kelemahannya sendiri. Kami membayangkan lapisan SQL terpadu, yang diaktifkan oleh dukungan Hive untuk SQL:2011, yang secara transparan menggunakan mesin yang sesuai berdasarkan pola akses kueri.

Kombinasi ini menyediakan satu dialek SQL dan konektor tunggal. Arsitek data dan DBA dapat menentukan di mana data harus disimpan berdasarkan pola penggunaan tanpa membebani aplikasi pengguna dengan kebutuhan untuk terhubung ke beberapa sistem.

2. Meningkatkan HBase sebagai Toko Operasional

HBase cepat matang sebagai toko operasional dan akan mampu mengambil beban kerja yang semakin banyak menuntut. Pada tahun lalu, HBase telah menambahkan antarmuka SQL, pengindeksan sekunder, dan ketersediaan tinggi. Fitur-fitur ini akan terus berkembang, dan sebagai tambahan, HBase akan menambahkan fitur tingkat perusahaan tambahan seperti multi-tabel, transaksi pusat data silang, dan banyak lagi.

Proyek seperti Omid (Yahoo), Tephra (

3. Katalog Metadata Bersama dan Manajer Transaksi

Data yang dibuat di HBase harus secara otomatis terlihat di Hive dan sebaliknya. Kemampuan ini membuat berbagi data antara online dan analitis benar-benar sepele. Manajer transaksi bersama memungkinkan fitur ACID baru Hive dan transaksi HBase multi-tabel untuk bekerja sama dengan mulus.

4. Dukungan Beban Kerja Campuran dengan YARN

Saat ini, pelanggan biasanya menggunakan HBase dan Hive di cluster terpisah. Mengembangkan sistem analitik loop tertutup memerlukan kombinasi yang efektif dari beban kerja operasional dan analitis dengan cara multi-penyewa. Dengan YARN kami dapat secara efektif membuat sistem tunggal dengan memanfaatkan isolasi sumber daya dan manajemen beban kerja primitif di YARN untuk mendukung berbagai bentuk akses ke data. Slider memanfaatkan ini ketika menyebarkan HBase ke dalam BENANG, sementara Hive LLAP &Tez adalah aplikasi BENANG asli, sehingga menyederhanakan proses menjalankan sistem analitik loop tertutup sesuai dengan SLA yang dapat diprediksi.

Kesimpulan

Perusahaan menggunakan teknologi yang sudah ada yang tersedia di HDP seperti Apache HBase, Apache Hive, Apache Phoenix, dll. untuk menangani pembaruan cepat terhadap data saat ini dan analitik melalui kumpulan data yang sangat banyak, semuanya disimpan dalam HDFS untuk menghasilkan sistem analitik loop tertutup . Kami berharap dapat memanfaatkan pola integrasi yang sama untuk memberikan pengalaman yang mulus bagi pelanggan dengan menjadikan Apache HBase dan Apache Hive lebih baik – bersama-sama lebih baik, daripada teknologi baru bersih untuk dipahami dan dikonsumsi pengguna.