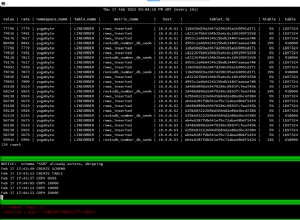

Spark JDBC API tampaknya bercabang untuk memuat semua data dari tabel MySQL ke memori tanpa. Jadi ketika Anda mencoba memuat tabel besar, yang harus Anda lakukan adalah menggunakan data clone Spark API ke HDFS terlebih dahulu (JSON harus digunakan untuk menjaga struktur skema), seperti ini:

spark.read.jdbc(jdbcUrl, tableName, prop)

.write()

.json("/fileName.json");

Kemudian Anda dapat mengerjakan HDFS secara normal.

spark.read().json("/fileName.json")

.createOrReplaceTempView(tableName);