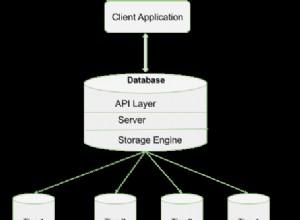

Anda tidak dapat menanyakan RDD secara langsung dengan cara ini. Pikirkan pekerjaan Spark Anda sebagai pemroses aliran. Apa yang dapat Anda lakukan adalah mendorong model yang diperbarui ke beberapa "toko", seperti database (dengan API khusus atau JDBC), sistem file, atau memcached. Anda bahkan dapat melakukan panggilan layanan web dari dalam kode Spark.

Apa pun yang Anda lakukan, berhati-hatilah agar waktu untuk memproses setiap kumpulan data, termasuk I/O, berada di bawah interval waktu yang Anda tentukan. Jika tidak, Anda berisiko mengalami kemacetan yang pada akhirnya mungkin macet.

Satu hal lain yang harus diperhatikan adalah kasus di mana Anda memiliki data model Anda di lebih dari satu partisi RDD yang tersebar di cluster, (yang tentu saja merupakan default). Jika urutan "catatan" Anda tidak penting, maka menuliskannya secara paralel tidak masalah. Jika Anda memerlukan total pesanan tertentu yang ditulis secara berurutan (dan datanya sebenarnya tidak besar), panggil collect untuk membawanya ke dalam satu struktur data dalam memori di dalam kode driver Anda (yang berarti lalu lintas jaringan dalam tugas terdistribusi), lalu tulis dari sana.