Basis Data Relasional untuk waktu yang lama sudah cukup untuk menangani kumpulan data kecil atau menengah. Tetapi tingkat pertumbuhan data yang sangat besar membuat pendekatan tradisional untuk penyimpanan dan pengambilan data menjadi tidak layak. Masalah ini sedang dipecahkan oleh teknologi baru yang dapat menangani Big Data. Hadoop, Hive, dan Hbase adalah platform populer untuk mengoperasikan kumpulan data besar semacam ini. Basis data NoSQL atau Not Only SQL seperti MongoDB® menyediakan mekanisme untuk menyimpan dan mengambil data dalam model konsistensi pecundang dengan keunggulan seperti:

- Penskalaan horizontal

- Ketersediaan lebih tinggi

- Akses lebih cepat

Tim teknik MongoDB® baru-baru ini memperbarui Konektor MongoDB® untuk Hadoop agar memiliki integrasi yang lebih baik. Ini memudahkan pengguna Hadoop untuk:

- Integrasikan data real-time dari MongoDB® dengan Hadoop untuk analisis offline yang mendalam.

- Konektor memaparkan kekuatan analitik MapReduce Hadoop ke data aplikasi langsung dari MongoDB®, mendorong nilai dari data besar lebih cepat dan lebih efisien.

- Konektor menyajikan MongoDB sebagai sistem file yang kompatibel dengan Hadoop yang memungkinkan pekerjaan MapReduce membaca dari MongoDB® secara langsung tanpa terlebih dahulu menyalinnya ke HDFS (Sistem file Hadoop), sehingga menghilangkan kebutuhan untuk memindahkan Terabyte data di seluruh jaringan.

- Pekerjaan MapReduce dapat meneruskan kueri sebagai filter, sehingga menghindari kebutuhan untuk memindai seluruh koleksi, dan juga dapat memanfaatkan kemampuan pengindeksan MongoDB® yang kaya termasuk geo-spasial, teks- indeks pencarian, larik, gabungan, dan jarang.

- Membaca dari MongoDB®, hasil pekerjaan Hadoop juga dapat ditulis kembali ke MongoDB®, untuk mendukung proses operasional waktu nyata dan kueri ad-hoc.

Kasus Penggunaan Hadoop dan MongoDB®:

Mari kita lihat deskripsi tingkat tinggi tentang bagaimana MongoDB® dan Hadoop dapat disatukan dalam tumpukan Data Besar pada umumnya. Terutama kami memiliki:

- MongoDB® digunakan sebagai penyimpanan data real-time “Operasional”

- Hadoop untuk pemrosesan dan analisis data batch offline

Baca terus untuk mengetahui mengapa MongoDB adalah database untuk pemrosesan Big Data dan bagaimana MongoDB® digunakan oleh perusahaan dan organisasi seperti Aadhar, Shutterfly, Metlife, dan eBay.

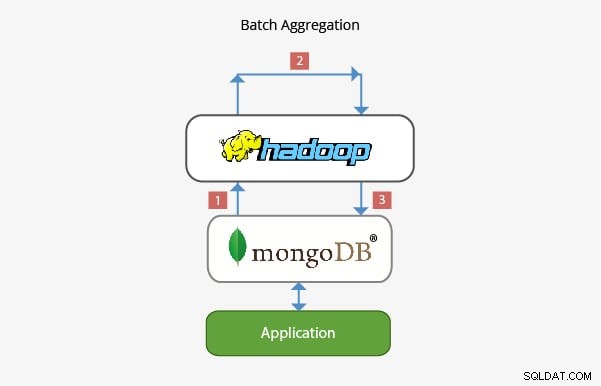

Aplikasi MongoDB® dengan Hadoop dalam Agregasi Batch:

Dalam kebanyakan skenario, fungsionalitas agregasi bawaan yang disediakan oleh MongoDB® cukup untuk menganalisis data. Namun dalam kasus tertentu, agregasi data yang jauh lebih kompleks mungkin diperlukan. Di sinilah Hadoop dapat menyediakan kerangka kerja yang kuat untuk analisis yang kompleks.

Dalam skenario ini:

- Data diambil dari MongoDB® dan diproses dalam Hadoop melalui satu atau lebih tugas MapReduce. Data juga dapat bersumber dari tempat lain dalam tugas MapReduce ini untuk mengembangkan solusi sumber multi-data.

- Output dari tugas MapReduce ini kemudian dapat ditulis kembali ke MongoDB® untuk kueri pada tahap selanjutnya dan untuk analisis apa pun secara ad-hoc.

- Aplikasi yang dibangun di atas MongoDB® karenanya dapat menggunakan informasi dari analisis batch untuk disajikan kepada klien akhir atau untuk mengaktifkan fitur hilir lainnya.

Aplikasi di Data Warehousing:

Dalam penyiapan produksi biasa, data aplikasi mungkin berada di beberapa penyimpanan data, masing-masing dengan bahasa kueri dan fungsionalitasnya sendiri. Untuk mengurangi kerumitan dalam skenario ini, Hadoop dapat digunakan sebagai gudang data dan bertindak sebagai gudang terpusat untuk data dari berbagai sumber.

Dalam skenario seperti ini:

- Pekerjaan Periodic MapReduce memuat data dari MongoDB® ke Hadoop.

- Setelah data dari MongoDB® dan sumber lain tersedia di Hadoop, kumpulan data yang lebih besar dapat dikueri.

- Analis data kini memiliki opsi untuk menggunakan MapReduce atau Pig untuk membuat pekerjaan yang mengkueri kumpulan data yang lebih besar yang menggabungkan data dari MongoDB®.

Tim yang bekerja di belakang MongoDB® telah memastikan bahwa dengan integrasi yang kaya dengan teknologi Big Data seperti Hadoop, ia dapat berintegrasi dengan baik di Big Data Stack dan membantu memecahkan beberapa masalah arsitektur yang kompleks dalam hal penyimpanan, pengambilan, pemrosesan, pengumpulan, dan pergudangan data. Nantikan postingan kami yang akan datang tentang prospek karir bagi mereka yang menggunakan Hadoop dengan MongoDB®. Jika Anda sudah bekerja dengan Hadoop atau hanya mengambil MongoDB®, periksa kursus yang kami tawarkan untuk MongoDB® di sini

Jelajahi lebih lanjut tentang konsep Hadoop. Lihat Kursus Data Besar Online . ini , yang dibuat oleh Pakar Pekerjaan Industri Teratas.