Kemajuan teknologi telah membawa keuntungan daripada yang perlu dimanfaatkan oleh organisasi bisnis untuk nilai keuntungan maksimum dan pengurangan biaya operasional. Data telah menjadi tulang punggung kemajuan teknologi ini dari mana prosedur canggih diturunkan untuk mencapai tujuan tertentu. Seiring kemajuan teknologi, ada lebih banyak data yang dibawa ke dalam sistem. Selain itu, seiring pertumbuhan bisnis, ada lebih banyak data yang terlibat dan pengaturan sistem penyajian perlu pemrosesan data yang cepat, andal dalam penyimpanan, dan menawarkan keamanan optimal untuk data ini. MongoDB adalah salah satu sistem yang dapat dipercaya dalam mencapai faktor-faktor tersebut.

Big Data mengacu pada data masif yang cepat berubah, dapat diakses dengan cepat, dan sangat tersedia untuk memenuhi kebutuhan secara efisien. Organisasi bisnis cenderung memeriksa silang pengaturan basis data yang tersedia yang akan memberikan kinerja terbaik seiring berjalannya waktu dan akibatnya menyadari beberapa nilai dari Big Data.

Misalnya, pasar online mengamati klik web klien, daya beli, dan kemudian menggunakan data turunan dalam menyarankan barang lain sebagai cara beriklan atau menggunakan data dalam penetapan harga. Robot belajar melalui pembelajaran mesin dan prosesnya jelas melibatkan banyak data yang dikumpulkan karena robot harus menyimpan apa yang telah dipelajarinya dalam memori untuk digunakan nanti. Menyimpan data kompleks semacam ini dengan perangkat lunak basis data tradisional dianggap tidak praktis.

Karakteristik Data Besar

Dalam sistem perangkat lunak, kami mempertimbangkan Big Data dalam hal ukuran, kecepatan akses, dan tipe data yang terlibat. Ini dapat direduksi menjadi 3 parameter:

- Volume

- Kecepatan

- Berbagai

Volume

Volume adalah ukuran Big Data yang terlibat dan berkisar dari gigabyte hingga terabyte atau lebih. Setiap hari, perusahaan besar menyerap terabyte data dari operasi harian mereka. Misalnya, sebuah perusahaan telekomunikasi ingin menyimpan catatan panggilan yang dilakukan sejak awal operasinya, pesan yang dikirim dan berapa lama setiap panggilan berlangsung. Setiap hari, ada banyak kegiatan ini yang terjadi sehingga menghasilkan banyak data. Data tersebut dapat digunakan dalam analisis statistik, pengambilan keputusan, dan perencanaan tarif.

Kecepatan

Pertimbangkan platform seperti perdagangan Forex yang membutuhkan pembaruan waktu nyata untuk semua mesin klien yang terhubung dan menampilkan pembaruan bursa saham baru secara waktu nyata. Ini menentukan bahwa basis data penyajian harus cukup cepat dalam memproses data tersebut dengan sedikit latensi. Beberapa game online yang melibatkan pemain dari lokasi dunia yang berbeda mengumpulkan banyak data dari klik, seret, dan gerakan pengguna lainnya, lalu menyampaikannya di antara jutaan perangkat dalam mikrodetik. Sistem database yang terlibat harus cukup cepat untuk melakukan semua ini secara real time.

Variasi

Data dapat dikategorikan dalam berbagai jenis mulai dari, angka, string, tanggal, objek, array, data biner, kode, data geospasial, dan ekspresi reguler hanya untuk menyebutkan beberapa. Sistem database yang optimal harus menyediakan fungsi untuk meningkatkan manipulasi data ini tanpa menimbulkan prosedur tambahan dari sisi klien. Misalnya, MongoDB menyediakan operasi geolokasi untuk penggunaan saat mengambil lokasi di dekat koordinat yang disediakan dalam kueri. Kemampuan ini tidak dapat dicapai dengan database tradisional karena mereka hanya dirancang untuk menangani struktur volume data yang kecil, pembaruan yang lebih sedikit, dan beberapa struktur data yang konsisten. Selain itu, seseorang akan membutuhkan operasi tambahan dalam mencapai beberapa tujuan tertentu, dalam kasus database tradisional.

MongoDB juga dapat dijalankan dari beberapa server sehingga murah dan tidak terbatas, bertentangan dengan database tradisional yang hanya dirancang untuk berjalan di satu server.

Faktor yang Perlu Dipertimbangkan Saat Memilih MongoDB untuk Big Data

Big Data membawa keuntungan perusahaan ketika dikelola dengan baik melalui kekuatan pemrosesan yang ditingkatkan. Ketika memilih sistem database, seseorang harus mempertimbangkan beberapa faktor mengenai jenis data yang akan Anda tangani dan apakah sistem yang Anda pilih menyediakan kemampuan itu. Di blog ini, kita akan membahas kelebihan yang ditawarkan MongoDB untuk Big Data dibandingkan dengan Hadoop dalam beberapa kasus.

- Bahasa kueri yang kaya untuk kueri dinamis

- Penyematan data

- Ketersediaan tinggi

- Pengindeksan dan Skalabilitas

- Mesin penyimpanan dan penanganan memori yang efisien

- Konsistensi dan integritas data

Bahasa Kueri yang Kaya untuk Kueri Dinamis

MongoDB paling cocok untuk Big Data di mana data yang dihasilkan memerlukan manipulasi lebih lanjut untuk output yang diinginkan. Beberapa sumber daya yang kuat adalah operasi CRUD, kerangka kerja agregasi, pencarian teks, dan fitur Pengurangan Peta. Dalam kerangka agregasi, MongoDB memiliki fungsionalitas geolokasi ekstra yang memungkinkan seseorang melakukan banyak hal dengan data geospasial. Misalnya, dengan membuat indeks 2Dsphere, Anda dapat mengambil lokasi dalam radius yang ditentukan hanya dengan memberikan koordinat lintang dan bujur. Mengacu pada contoh telekomunikasi di atas, perusahaan dapat menggunakan fitur pengurangan Peta atau kerangka kerja agregasi untuk mengelompokkan panggilan dari lokasi tertentu, menghitung waktu panggilan rata-rata setiap hari untuk penggunanya atau lebih banyak operasi lainnya. Periksa contoh di bawah ini.

Mari kita kumpulkan lokasi dengan datanya

{ name: "KE",loc: { type: "Point", coordinates: [ -73.97, 40.77 ] }, category: "Parks"}

{ name: "UG",loc: { type: "Point", coordinates: [ -45.97, 40.57 ] }, category: "Parks"}

{ name: "TZ",loc: { type: "Point", coordinates: [ -73.27, 34.43 ] }, category: "Parks"}

{ name: "SA",loc: { type: "Point", coordinates: [ -67.97, 40.77 ] }, category: "Parks"}Kami kemudian dapat menemukan data untuk lokasi yang dekat [-73,00, 40.00] menggunakan kerangka kerja agregasi dan dalam jarak 1KM dengan kueri di bawah ini:

db.places.aggregate( [

{

$geoNear: {

near: { type: "Point", coordinates: [ -73.00, 40.00 ] },

spherical: true,

query: { category: "Parks" },

distanceField: "calcDistance",

maxDistance: 10000

}

}

]Operasi Pengurangan Peta juga tersedia di Hadoop tetapi cocok untuk permintaan sederhana. Proses iteratif untuk Big Data menggunakan Map-Reduce di Hadoop cukup lambat daripada di MongoDB. Alasan di baliknya adalah, tugas iteratif membutuhkan banyak pemetaan dan proses reduksi sebelum selesai. Dalam prosesnya, banyak file dihasilkan di antara peta dan mengurangi tugas sehingga tidak dapat digunakan dalam analisis lanjutan. MongoDb memperkenalkan kerangka kerja pipa agregasi untuk mengurangi kemunduran ini dan ini adalah yang paling banyak digunakan belakangan ini.

Penyematan Data

MongoDB berbasis dokumen dengan kemampuan untuk menempatkan lebih banyak bidang di dalam satu bidang yang disebut sebagai penyematan. Penyematan hadir dengan keuntungan dari kueri minimal yang dikeluarkan untuk satu dokumen karena dokumen itu sendiri dapat menampung banyak data. Untuk database relasional di mana seseorang mungkin memiliki banyak tabel, Anda harus mengeluarkan beberapa kueri ke database untuk tujuan yang sama.

Ketersediaan Tinggi

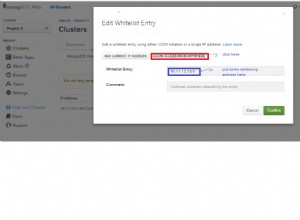

Replikasi data di beberapa host dan server sekarang dimungkinkan dengan MongoDB, tidak seperti DBMS relasional di mana replikasi dibatasi untuk satu server. Ini menguntungkan karena data sangat tersedia di lokasi yang berbeda dan pengguna dapat dilayani secara efisien oleh server terdekat. Selain itu, proses pemulihan atau kerusakan mudah dicapai mengingat fitur penjurnalan di MongoDB yang membuat pos pemeriksaan tempat proses pemulihan dapat dirujuk.

Pengindeksan dan Skalabilitas

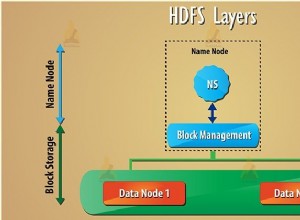

Pengindeksan primer dan sekunder di MongoDB hadir dengan banyak manfaat. Pengindeksan membuat kueri dieksekusi terlebih dahulu yang merupakan pertimbangan yang diperlukan untuk Big Data seperti yang telah kita bahas di bawah karakteristik kecepatan untuk Big Data. Pengindeksan juga dapat digunakan dalam membuat pecahan. Pecahan dapat didefinisikan sebagai sub-koleksi yang berisi data yang telah didistribusikan ke dalam kelompok menggunakan kunci pecahan. Saat kueri dikeluarkan, kunci pecahan digunakan untuk menentukan tempat mencari di antara pecahan yang tersedia. Jika tidak ada pecahan, prosesnya akan memakan waktu cukup lama untuk Big Data karena semua dokumen harus diperiksa dan prosesnya bahkan mungkin habis sebelum pengguna mendapatkan apa yang mereka inginkan. Namun dengan sharding, jumlah data yang akan diambil berkurang dan akibatnya mengurangi latensi menunggu kueri dikembalikan.

Mesin Penyimpanan dan Penanganan Memori yang Efisien

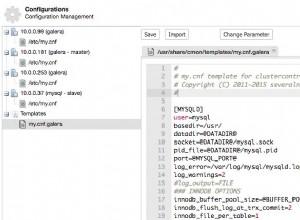

Versi MongoDB terbaru menetapkan WiredTiger sebagai mesin penyimpanan default yang memiliki kemampuan eksekutif untuk menangani banyak beban kerja. Mesin penyimpanan ini memiliki banyak keuntungan untuk melayani Big Data seperti yang dijelaskan dalam artikel ini. Engine ini memiliki fitur seperti kompresi, checkpointing, dan mempromosikan beberapa operasi penulisan melalui dokumen-konkurensi. Big Data berarti banyak pengguna dan fitur konkurensi tingkat dokumen akan memungkinkan banyak pengguna untuk mengedit dalam database secara bersamaan tanpa menimbulkan kemunduran kinerja. MongoDB telah dikembangkan menggunakan C++ sehingga baik untuk penanganan memori.

Konsistensi dan Integritas Data

Alat validator JSON adalah fitur lain yang tersedia di MongoDB untuk memastikan integritas dan konsistensi data. Ini digunakan untuk memastikan data yang tidak valid tidak masuk ke database. Misalnya, jika ada bidang yang disebut usia, itu akan selalu mengharapkan nilai Integer. Validator JSON akan selalu memeriksa bahwa string atau tipe data lainnya tidak dikirimkan untuk penyimpanan ke database untuk bidang ini. Ini juga untuk memastikan bahwa semua dokumen memiliki nilai untuk bidang ini dalam tipe data yang sama sehingga konsistensi data. MongoDB juga menawarkan fitur Pencadangan dan pemulihan sehingga jika terjadi kegagalan, seseorang dapat kembali ke keadaan yang diinginkan.

Kesimpulan

MongoDB menangani analisis data waktu nyata dengan cara yang paling efisien sehingga cocok untuk Big Data. Misalnya, pengindeksan geospasial memungkinkan analisis data GPS secara real time.

Selain konfigurasi keamanan dasar, MongoDB memiliki alat validasi data JSON tambahan untuk memastikan hanya data yang valid yang masuk ke database. Karena basis data berbasis dokumen dan bidang telah disematkan, sangat sedikit kueri yang dapat dikeluarkan ke basis data untuk mengambil banyak data. Ini membuatnya ideal untuk digunakan saat terkait dengan Big Data.