Transformasi digital adalah topik hangat untuk semua pasar dan industri karena memberikan nilai dengan tingkat pertumbuhan yang eksplosif. Pertimbangkan bahwa Industri Internet of Things (IIOT) Manufaktur bernilai $ 161 miliar dengan tingkat pertumbuhan 25% yang mengesankan, pasar Mobil Terhubung akan bernilai $ 225 miliar pada tahun 2027 dengan tingkat pertumbuhan 17%, atau dalam tiga bulan pertama Tahun 2020, peritel merealisasikan penetrasi penjualan digital selama sepuluh tahun hanya dalam waktu tiga bulan. Namun, sebagian besar dari apa yang tertulis berkaitan dengan platform teknologi yang memungkinkan (solusi cloud atau edge atau titik seperti gudang data) atau kasus penggunaan yang mendorong manfaat ini (analisis prediktif yang diterapkan pada pemeliharaan preventif, deteksi penipuan lembaga keuangan, atau pemantauan kesehatan prediktif sebagai contoh) bukan data yang mendasarinya. Bab yang hilang bukan tentang solusi titik atau perjalanan kedewasaan kasus penggunaan. Bab yang hilang adalah tentang data–selalu tentang data–dan, yang paling penting, data perjalanan terjalin dari tepi ke wawasan kecerdasan buatan.

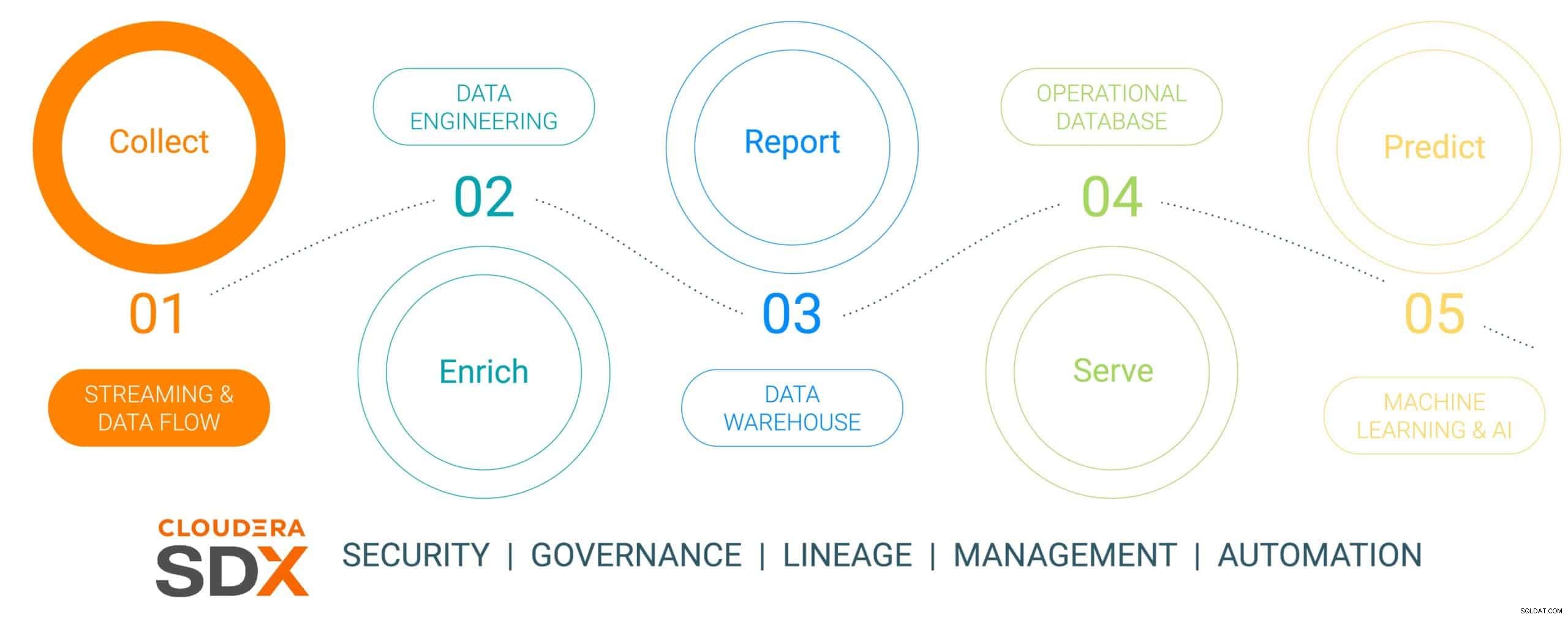

Ini adalah seri blog enam bagian pertama yang menguraikan perjalanan data dari edge ke AI dan data nilai bisnis yang dihasilkan sepanjang perjalanan. Perjalanan data tidak linier, tetapi merupakan siklus hidup data loop tak terbatas – dimulai dari edge, merajut melalui platform data, dan menghasilkan wawasan penting bisnis yang diterapkan pada masalah bisnis-penting nyata yang menghasilkan inisiatif berbasis data baru. Kami telah menyederhanakan perjalanan ini menjadi lima langkah terpisah dengan langkah keenam yang umum berbicara tentang keamanan dan tata kelola data. Keenam langkah tersebut adalah:

- Pengumpulan Data – penyerapan data dan pemantauan di edge (apakah edge menjadi sensor industri atau orang di toko ritel batu bata dan mortir)

- Pengayaan Data – pemrosesan pipa data, agregasi &manajemen untuk menyiapkan data untuk penyempurnaan lebih lanjut

- Pelaporan – memberikan wawasan perusahaan bisnis (analisis dan perkiraan penjualan, riset pasar, penganggaran sebagai contoh)

- Menyajikan – mengendalikan dan menjalankan operasi bisnis penting (transaksi ATM, pembayaran retail, atau pemantauan produksi)

- Analisis Prediktif – analisis prediktif berdasarkan AI dan pembelajaran mesin (Deteksi penipuan, pemeliharaan prediktif, pengoptimalan inventaris berbasis permintaan sebagai contoh)

- Keamanan &Tata Kelola – seperangkat teknologi keamanan, manajemen, dan tata kelola yang terintegrasi di seluruh siklus hidup data

Gambar 1:Siklus Hidup Data Perusahaan

Untuk mengilustrasikan perjalanan data, kami telah memilih topik manufaktur yang sangat relevan dan berpikiran berkelanjutan – pembuatan mobil listrik, dipilih karena operasi manufaktur biasanya bersifat revolusioner (maturitas digital tinggi yang menggunakan alat data paling mutakhir) , dibandingkan dengan "evolusioner jadul" (dengan kematangan yang lebih rendah) dan bahwa sebagian besar mobil ini dibuat sebagai platform Connected Mobility yang menjadikan mobil lebih dari sekadar transportasi, tetapi juga platform untuk pengetahuan dan wawasan yang didukung data. Kisah ini akan menunjukkan bagaimana data dikumpulkan, diperkaya, disimpan, disajikan, dan kemudian digunakan untuk memprediksi peristiwa dalam proses pembuatan mobil menggunakan Cloudera Data Platform.

Cerita ini akan menampilkan perusahaan manufaktur kendaraan listrik tiruan yang terhubung yang disebut (dengan nama yang sangat asli) Perusahaan Mobil Listrik (ECC). ECC mengoperasikan beberapa pabrik manufaktur yang berlokasi di seluruh dunia, terintegrasi secara vertikal membangun mobilnya sendiri serta banyak komponen penting, termasuk motor listrik, baterai, dan suku cadang tambahan. Setiap pabrik dibebankan untuk memproduksi komponen yang berbeda dengan perakitan akhir berlangsung di beberapa pabrik terpilih yang berlokasi strategis.

Tantangan Pengumpulan Data

Mengelola pengumpulan semua data dari semua pabrik dalam proses manufaktur adalah tugas penting yang menghadirkan beberapa tantangan:

- Kesulitan menilai volume dan variasi data IoT: Banyak pabrik menggunakan aset dan perangkat manufaktur modern dan lama dari berbagai vendor, dengan berbagai protokol dan format data. Meskipun pengontrol dan perangkat mungkin terhubung ke sistem OT, mereka biasanya tidak terhubung sedemikian rupa sehingga mereka dapat dengan mudah berbagi data dengan sistem TI juga. Untuk mengaktifkan manufaktur yang terhubung dan kasus penggunaan IoT yang muncul, ECC membutuhkan solusi yang dapat menangani semua jenis struktur dan skema data yang beragam dari edge, menormalkan data, dan kemudian membagikannya dengan semua jenis konsumen data termasuk aplikasi Big Data.

- Mengelola kompleksitas data waktu nyata: Agar ECC mendorong kasus penggunaan analitik prediktif, platform manajemen data perlu mengaktifkan analitik real-time pada data streaming. Platform juga perlu secara efektif menyerap, menyimpan, dan memproses data streaming secara real-time atau hampir real-time untuk memberikan wawasan dan tindakan secara instan.

- Membebaskan data dari silo independen: Proses khusus (platform inovasi, QMS, MES, dll.) dalam rantai nilai manufaktur memberi penghargaan pada sumber data yang berbeda dan platform manajemen data yang disesuaikan dengan solusi unik. Solusi khusus ini membatasi nilai perusahaan, dengan mempertimbangkan hanya sebagian kecil dari wawasan yang dapat ditawarkan oleh data lintas-perusahaan, sambil membagi bisnis dan membatasi peluang kolaborasi. Platform yang tepat harus memiliki kemampuan untuk menyerap, menyimpan, mengelola, menganalisis, dan memproses data streaming dari semua titik dalam rantai nilai, menggabungkannya dengan sumber Data Historian, ERP, MES, dan QMS, serta memanfaatkannya menjadi wawasan yang dapat ditindaklanjuti. Wawasan ini akan memberikan dasbor, laporan, dan analitik prediktif yang mendorong kasus penggunaan manufaktur bernilai tinggi.

- Menyeimbangkan keunggulan: Memahami keseimbangan yang tepat antara pemrosesan data di edge dan di cloud adalah sebuah tantangan, dan inilah mengapa seluruh siklus hidup data perlu dipertimbangkan. Ada tren yang meresahkan dalam industri karena perusahaan memilih untuk fokus pada satu atau yang lain tanpa menyadari bahwa mereka dapat, dan harus, melakukan keduanya. Komputasi awan memiliki manfaat untuk analisis jangka panjang dan penyebaran skala besar, tetapi dibatasi oleh bandwidth dan sering mengumpulkan data dalam jumlah besar sementara hanya menggunakan sebagian kecil. Nilai edge terletak pada tindakan di edge yang memiliki dampak terbesar dengan latensi nol sebelum mengirimkan data paling berharga ke cloud untuk pemrosesan performa tinggi lebih lanjut.

Pengumpulan Data Menggunakan Platform Data Cloudera

LANGKAH 1:Mengumpulkan data mentah

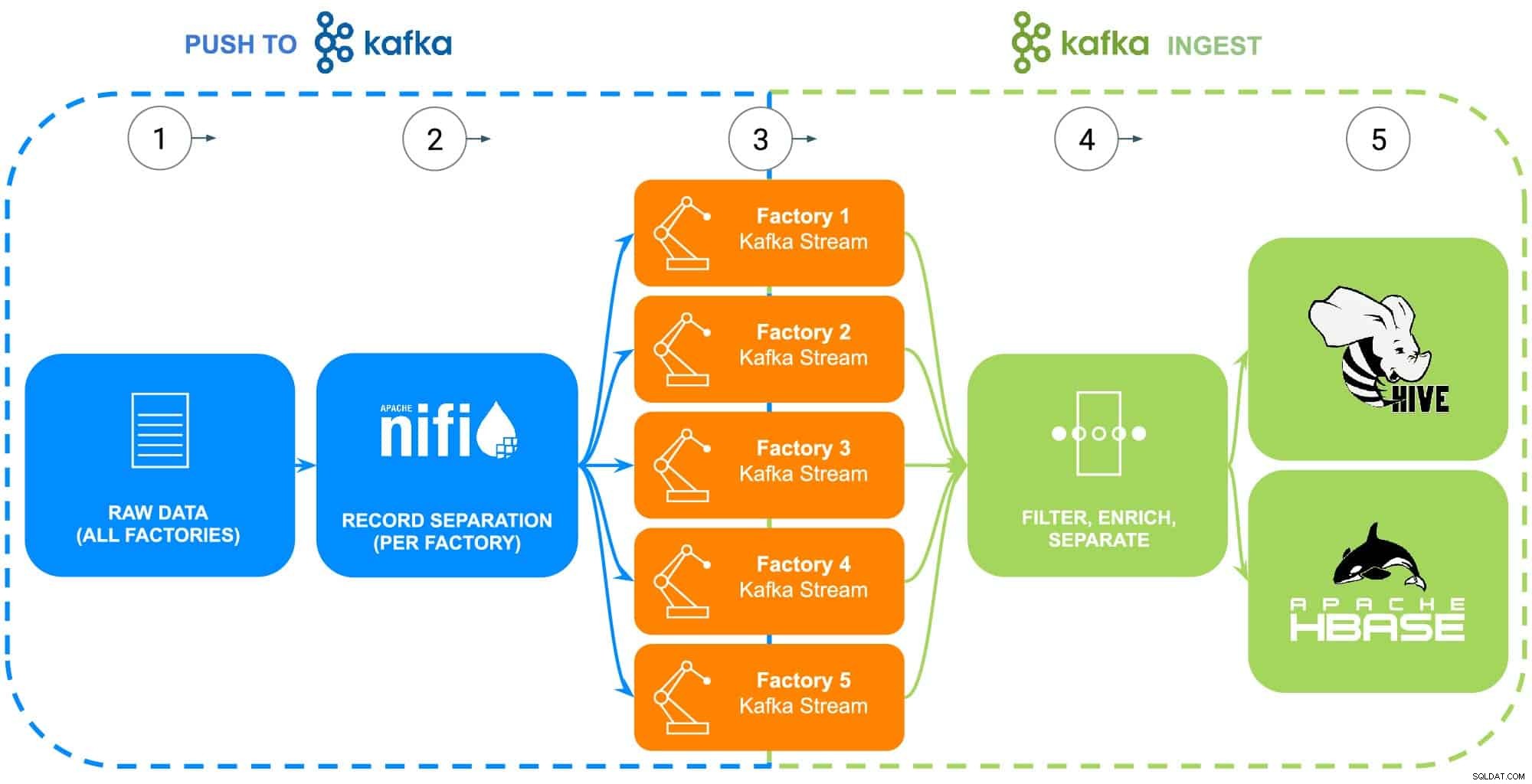

Data dari operasi manufaktur ECC mencakup banyak sumber – robot industri, tangki proses pelapisan fosfat body-in-white (suhu, konsentrasi atau pengisian ulang), telematika rantai pasokan, atau informasi bagian utama, dll. Untuk contoh khusus ini, bagian mentah data master untuk masing-masing dari lima pabrik ECC telah dikumpulkan sebagai persiapan untuk diumpankan ke Apache NiFi (lihat Gambar 2).

LANGKAH 2:Konfigurasikan sumber data untuk setiap pabrik

Pengumpulan data akan diilustrasikan menggunakan pengalaman Aliran Data Cloudera (didukung oleh Apache NiFi) untuk mengambil data mentah ini dan membaginya menjadi aliran pabrik individual (dikelola oleh Apache Kafka) agar lebih akurat menyerupai skenario dunia nyata (lihat Gambar 2). Agar contoh tetap sederhana, tag atribut data berikut dipilih untuk setiap bagian yang dihasilkan oleh pabrik:

- ID Pabrik

- ID Mesin

- Stempel waktu yang dibuat

- Nomor bagian

- Nomor seri

Gambar 2:Diagram alir pengumpulan data.

LANGKAH 3:Pantau throughput data dari setiap pabrik

Dengan semua data sekarang mengalir ke aliran Kafka individu, seorang arsitek data memantau throughput data dari setiap pabrik serta menyesuaikan sumber daya komputasi dan penyimpanan yang diperlukan untuk memastikan bahwa setiap pabrik memiliki throughput yang diperlukan untuk mengirim data ke platform.

LANGKAH 4:Ambil data dari aliran Apache Kafka

Kafka menangkap semua aliran data pabrik dan mengumpulkannya ke dalam prosesor yang akan menyaring dan memperkaya untuk digunakan dalam mengendalikan dan menjalankan operasi bisnis penting yang didukung oleh database operasional, atau memberikan wawasan perusahaan bisnis melalui gudang data perusahaan atau digunakan dalam analitik tingkat lanjut.

ECC baru-baru ini memulai produksi versi upgrade motor listrik mereka yang hanya diproduksi di Pabrik 5, data ini akan digunakan sebagai ilustrasi langkah selanjutnya dalam siklus hidup data

LANGKAH 5:Dorong data ke solusi penyimpanan

Karena para insinyur manufaktur dan kualitas ECC ingin memantau secara dekat penerapan dan penggunaan di lapangan motor ini, data ketertelusuran manufaktur tertentu disaring ke dalam rute terpisah dan disimpan ke dalam tabelnya sendiri di Apache Hive. Ini akan memungkinkan para insinyur untuk menjalankan kueri ad-hoc di Cloudera Data Warehouse terhadap data nanti serta menggabungkannya ke data lain yang relevan di gudang data perusahaan, seperti pesanan perbaikan atau umpan balik pelanggan untuk menghasilkan kasus penggunaan lanjutan seperti garansi, prediktif rutinitas pemeliharaan, atau masukan pengembangan produk.

Atau, jika diinginkan untuk mengontrol dan menjalankan operasi bisnis penting, seluruh kumpulan data dengan tambahan stempel waktu yang diproses akan dikirim ke Basis Data Operasional Cloudera yang didukung Apache HBase. Data ini akan menjadi dasar bagi ECC untuk menjalankan platform inventaris mereka, yang akan memerlukan penggunaan operasi baca/tulis yang konstan karena inventaris dapat ditambahkan dan dihapus ribuan kali per hari. Karena HBase dirancang untuk menangani jenis transaksi data ini dalam skala besar, HBase berfungsi sebagai solusi terbaik untuk tantangan unik ini.

Kesimpulan

Ilustrasi sederhana ini menunjukkan pentingnya mendapatkan penyerapan data yang benar, karena ini merupakan dasar untuk wawasan yang disampaikan dari database operasional, gudang data perusahaan, atau analitik pembelajaran mesin analitik prediktif tingkat lanjut. Nilai dalam "melakukannya dengan benar" termasuk menggunakan data dari sumber perusahaan mana pun sehingga memecah silo data, menggunakan semua data apakah itu berorientasi streaming atau batch, dan kemampuan untuk mengirim data itu ke tempat yang tepat menghasilkan wawasan hilir yang diinginkan.

Dengan menggunakan CDP, insinyur data ECC dan pengguna lini bisnis lainnya dapat mulai menggunakan data yang dikumpulkan untuk berbagai tugas mulai dari manajemen inventaris hingga perkiraan suku cadang hingga pembelajaran mesin. Karena Cloudera Data Flow mempromosikan penyerapan data real-time dari sumber perusahaan mana pun, itu dapat diperluas dan dipelihara tanpa pengetahuan yang luas tentang berbagai bahasa pemrograman dan metodologi pengumpulan data eksklusif. Jika masalah unik ditemukan, teknisi juga dapat membuat proses mereka sendiri untuk kontrol yang benar-benar halus.

Carilah blog berikutnya yang akan menyelidiki pengayaan data dan bagaimana hal itu mendukung kisah siklus hidup data. Selain itu, cerita ini akan ditambah dengan demo berbasis data yang menunjukkan perjalanan data melalui setiap langkah siklus hidup data.

Sumber Daya Pengumpulan Data Lebih Banyak

Untuk melihat semua ini beraksi, silakan klik tautan terkait di bawah ini untuk mempelajari Pengumpulan Data lebih lanjut:

- Video – Jika Anda ingin melihat dan mendengar bagaimana ini dibuat, lihat video di tautan.

- Tutorial – Jika Anda ingin melakukannya dengan kecepatan Anda sendiri, lihat panduan terperinci dengan tangkapan layar dan petunjuk baris demi baris tentang cara menyiapkan dan menjalankannya.

- Meetup – Jika Anda ingin berbicara langsung dengan pakar dari Cloudera, silakan bergabung dengan meetup virtual untuk melihat presentasi streaming langsung. Akan ada waktu untuk tanya jawab langsung di akhir.

- Pengguna – Untuk melihat lebih banyak konten teknis khusus untuk pengguna, klik tautannya.